- Home

- Categorie

- Digital Marketing

- SEO

- Google December 2020 Core Update: parliamone!

-

@giorgiotave Ottima risorsa, grazie. Tutto molto più chiaro. Come dicevo infatti la mia visione è molto limitata a siti prettamente editoriali. Anche il post tra i looser mi pare evidenziare chi fa troppo abuso del generalismo approfittando troppo del trust del dominio. Non vedo l'ora di guardare il video con la tua analisi.

-

@giorgiotave io non ero su discover prima e non sono su discover adesso

-

@giorgiotave devo dire che l'aggiornamento si è notato non poco. Google Analitics mi dice che c'è stato un calo del 27,3%. Da 2000 utenti giornalieri si è passato a 1400 utenti giornalieri. Spero che sia una cosa momentanea e si possa riprendere quota.

Grazie mille Giorgio per tutte le belle iniziative che fai e per la divulgazione professionale che offri.

-

@giorgiotave confermo parzialmente il dato di nospoiler.it diciamo no 40% ma siamo a 30% sabato e domenica, ma come si sa dobbiamo aspettare.... sembra che google stia facendo una rivalutazione di tutte le pagine.

Da ieri ho fluttuazioni veramente importanti in positivo e pian piano si sta tornando alla normalità di mercoledì 02-12

Variazioni di oggi:

2 Risposte

-

@sergio-valsecchi Aggiornamento o no, hai un sitone. Bello bello bello

-

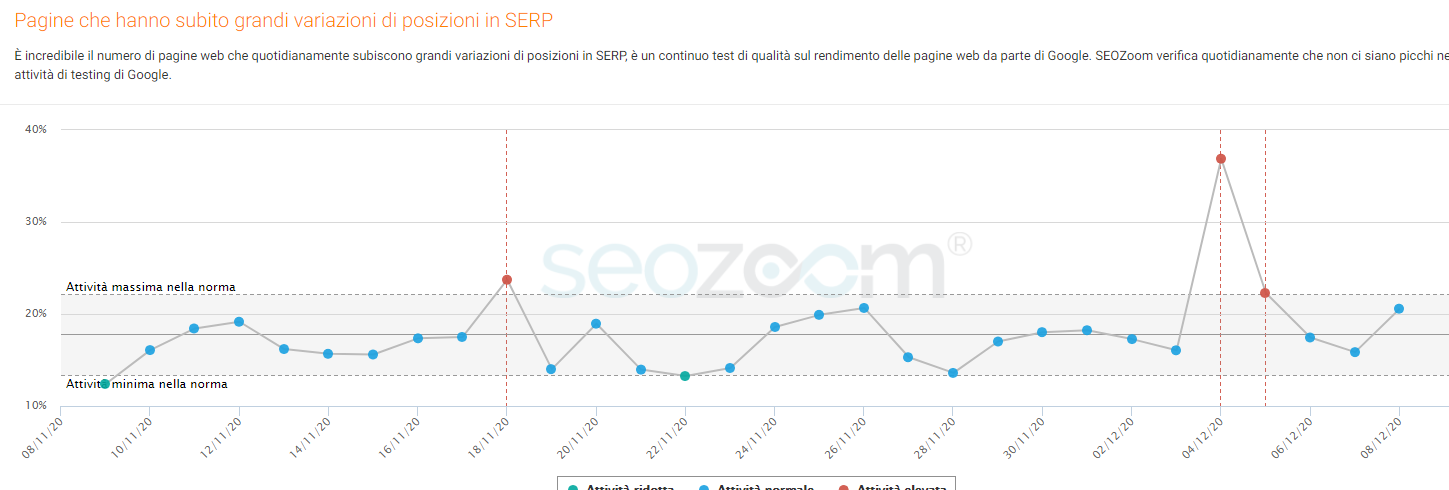

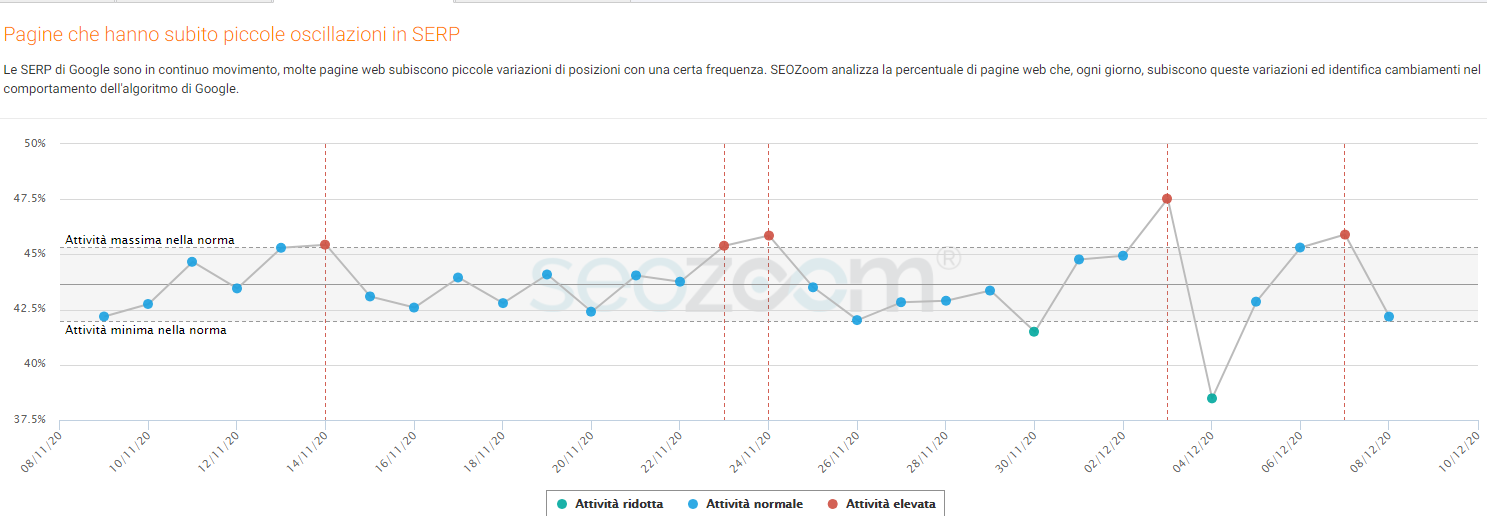

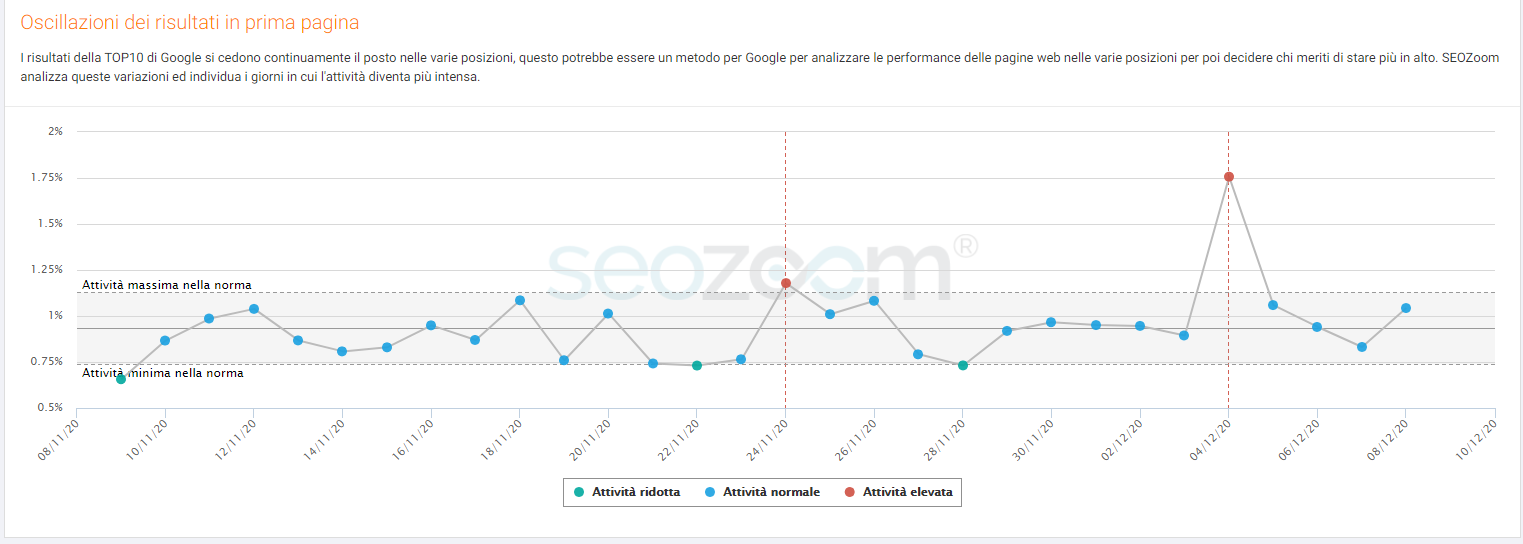

Riporto quanto in analisi sulle variazioni da parte di SeoZoom

Personalmente non vedo grosse variazioni sui miei clienti. Staremo a vedere... certo che sinceramente spero che BigG si rimetta in linea.. perché è un anno.. o forse più che vedo cose che li... non dovrebbero esserci.

-

@sergio-valsecchi Ciao Sergio, quindi cosa ne deduci sul comportamento dell'update?

S 1 Risposta -

@merlinox

Al momento deduco che google fa veramente quello che vuole

Anche oggi ho delle variazioni in positivo su volumi molto alti, la cosa "strana" che ho nuovi ingressi in Top10 che pre cove update non consideravo neanche di posizionare.

In generale sto in attesa ancora qualche giorni prima di tirare le somme.

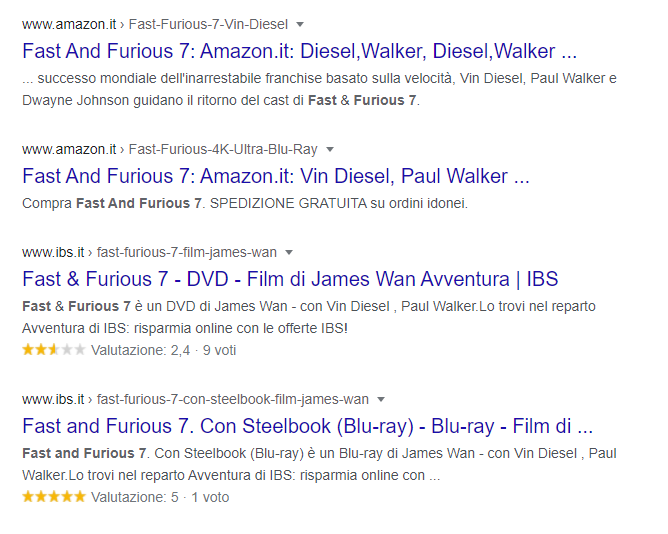

La cosa estremamente strana è che molto spesso su alcune query monitorate es. fast and furious 7 dove è chiaro l'abbaglio dell'update su Nospoiler.it ma mi trovo anche la duplicazione di nomedominio nella serp

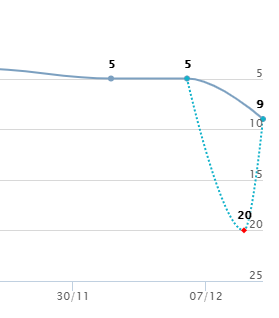

Andamento fast and furious 7

Posizione 6/7 e 8/9 con duplicazione di dominio (già notata ieri su altre query che oggi si sono risolte)

Mi sarei aspettato visto la situazione una scansione molto alta del sito invece c'è un calo...sto cercando di analizzare quali pagine ha escluso per capire se sono quelle pagine che non reputa di valore e escluse dalla serp

Tirando le somme ad oggi, l'update sta girando ancora

1 Risposta

-

@sergio-valsecchi grazie per la risposta. Leggo con molto piacere le analisi che condividete: io per ora non ne sto facendo per scelta: non so se giusta o sbagliata

-

Secondo me è abbastanza peregrino fare analisi di carattere generale.

Oramai dovremmo esserci abituati a questi update che premiano di botto qualcuno e svalutano di botto qualcun altro... sono cose che succedono quando in un algoritmo aggiorni i classificatori basati su reti neurali.

I siti che "rimbalzano" sono solitamente i siti "sul confine" dei vari classificatori e che vengono di conseguenza ri-classificati dato che sono cambiate le condizioni di giudizio.

Ed il fatto che oggi siano promossi non da garanzia alcuna sul fatto che possano essere bocciati al prossimo aggiornamento.

Anzi, i siti che non si migliorano e restano (come detto sopra "sul confine") è probabile che si trovino a rimbalzare molte altre volte in su ed in giù, come abbiamo ormai visto in moltissimi casi ad oggi.

Come al solito direi, la strada tracciata è la stessa: migliorare la pertinenza e la UX dei siti web, un pezzo alla volta, tagliando i rami secchi e facendo crescere le chiome rigogliose che danno frutto.

Non vedo grosse lezioni da trarre da questo, così come da precedenti o anche futuri update.

1 Risposta

-

@kal Assolutamente d'accordo, ormai, se perdi traffico, vuol dire che non sei più pertinente con i trend di interesse degli utenti

1 Risposta

-

@davide-del-medico bisogna però secondo me distinguere tra "perdere traffico" e "perdere traffico di botto in seguito all'aggiornamento".

Il primo caso è certamente come dici tu: il sito non resta al passo.

Il secondo caso invece è più complesso.

Ci sono in effetti molti casi in cui il sito perde sì traffico... Ma non perde in alcun modo conversioni, perché è Google che lo ha classificato meglio e quindi gli "toglie" traffico che però non era in linea.

Oppure ci sono i casi di siti "utili ma non straordinari" che in seguito all'aggiornamento del classificatore finiscono dalla parte dei penalizzati, ma più per sciatteria che demerito.

Insomma, è uno scenario complesso e per questo ribadisco quanto scritto sopra: è sbagliato aspettarsi di trarre delle regole da un update, se non le solite tre quattro di carattere iper-generale.

1 Risposta

-

@kal Per quanto capisca il tuo discorso, io mi chiedo ancora perché Google non abbia ancora imparato a diluire l'effetto dei suoi update

1 Risposta

-

@davide-del-medico perché è impossibile diluire l'effetto dell'aggiornamento di un classificatore basato su reti neurali.

Il classificatore usa metodi statistici avanzati (in altre parole, il machine learning), ma divide in modo netto il "grano" dalla "pula".

Questa cosa quando viene rilasciata sui vari datacenter ha l'effetto di una cesura netta sul traffico dei siti.

-

Basterebbe diluire l'uso del vecchio con l'uso del nuovo, evidentemente non è interesse di Google farlo

-

Per aggiungere carne al fuoco

https://www.pathinteractive.com/blog/seo/1000-winners-and-losers-of-the-december-2020-google-core-algorithm-update/Per quelli interessati ai dati. Anche se secondo me, poi, non ci cavi un ragno dal buco.

-

Secondo me analizzare per categorie ha poco senso.

Ha già più senso analizzare per singolo sito.

Ad esempio, come questo citato in calce all'articolo di Lily Ray:

Si vede benissimo che il sito è "sull'orlo" del classificatore, come dicevo sopra... perché sono anni che fa alti e bassi in modo netto e drastico.

Probabilmente in anni non hanno mai aggiustato il loro modello di business e infatti si può vedere come nel tempo abbiano comunque avuto un tendenziale trend discendente.

E' un sito editoriale ad argomento salute. Hanno sicuramente cercato di fare il massimo possibile sul piano dell'EAT di cui abbiamo sentito parlare alla nausea... ma evidentemente non basta.

A mio parere a rendere questo sito perennemente "a rischio" è la modalità di monetizzazione... ovvero: annunci pubblicitari.

Voi direte: e come altrimenti può fare un sito editoriale a sostenersi?

Bella domanda.

Quel che so di certo è che non ci fai bella figura se da un lato fornisci informazioni sullo stato di salute (argomento delicatissimo!!) e poi fai pubblicità, correlata o scorrelata che sia.

Possiamo girarci attorno finché volete, ma è evidente che qualcosa qui sia "fuori posto".

E gli annunci pubblicitari, piaccia o non piaccia, sono parte integrante del contenuto di pagina.

S 1 Risposta -

@kal sono arrivato alla tua stessa deduzione anche sui siti penalizzati tra cui il nostro già citato nel thread.

Ho fatto anche una valutazione di quanti siti sotto la stessa concessionaria simili al mio hanno avuto un drastico down... la sorpresa era dietro l'angolo!

Ti tralascio l'analisi delle performance delle chiamate agli ad serve e la quantità di ads caricata. Credo di fare un test drastico dopo un primo step di ottimizzazione del CLS.

Settimana prossima sego tutta l'ads e sto a vedere se effettivamente il punto delle line guida "Does the content have an excessive amount of ads that distract from or interfere with the main content?" incide su questo update.

1 Risposta

-

@sergio-valsecchi ma secondo me non è neanche una questione di "excessive amount of ads".

Il sito che ho citato sopra non ha quella che definirei una "excessive amount of ads". C'ha il minimo sindacale, in posti che non danno nemmeno fastidio.

Il problema è che si tratta di un sito di salute.

Mi sbaglierò, ma sui siti di salute probabilmente per chi li visita, "excessive amount of ads" significa una qualunque quantità di annunci > 0.

Ad esempio, prendete i siti governativi che vengono premiati dagli update. Oltre al fatto che sono fonti "trusted"... hanno anche ZERO ANNUNCI.

Poi naturalmente bisognerebbe aprire il capitolo "e come fa un sito editoriale a tema salute a campare?". Domanda a cui volutamente non rispondo HAHAH...

S2 Risposte

-

@kal si si chiaro! ma ti giuro che il nostro a volte da risoluzione 1366x768 non vedevi il contenuto e quindi qualche domande te le fai

Se funziona almeno so cosa può aver impattato con questo "core"