- Home

- Categorie

- Digital Marketing

- Intelligenza Artificiale

- Ho provato DeepSeek in locale sul mio PC e...

-

Ho provato DeepSeek in locale sul mio PC e...

... e niente, volevo fare un piccolo resoconto sulla mia esperienza che vada un po' oltre ad un post lapidario sui social. Quindi questo è il posto giusto.

Premesse

Ho un PC ben equipaggiato con una scheda video Geforce GTX 4070Ti che ho preso "per lavoro"

e infatti ci faccio girare

e infatti ci faccio girare i giochinii modelli di linguaggio perché:- è divertente

- è una tecnologia interessante

- mi permette di capire meglio cosa sono e come funzionano

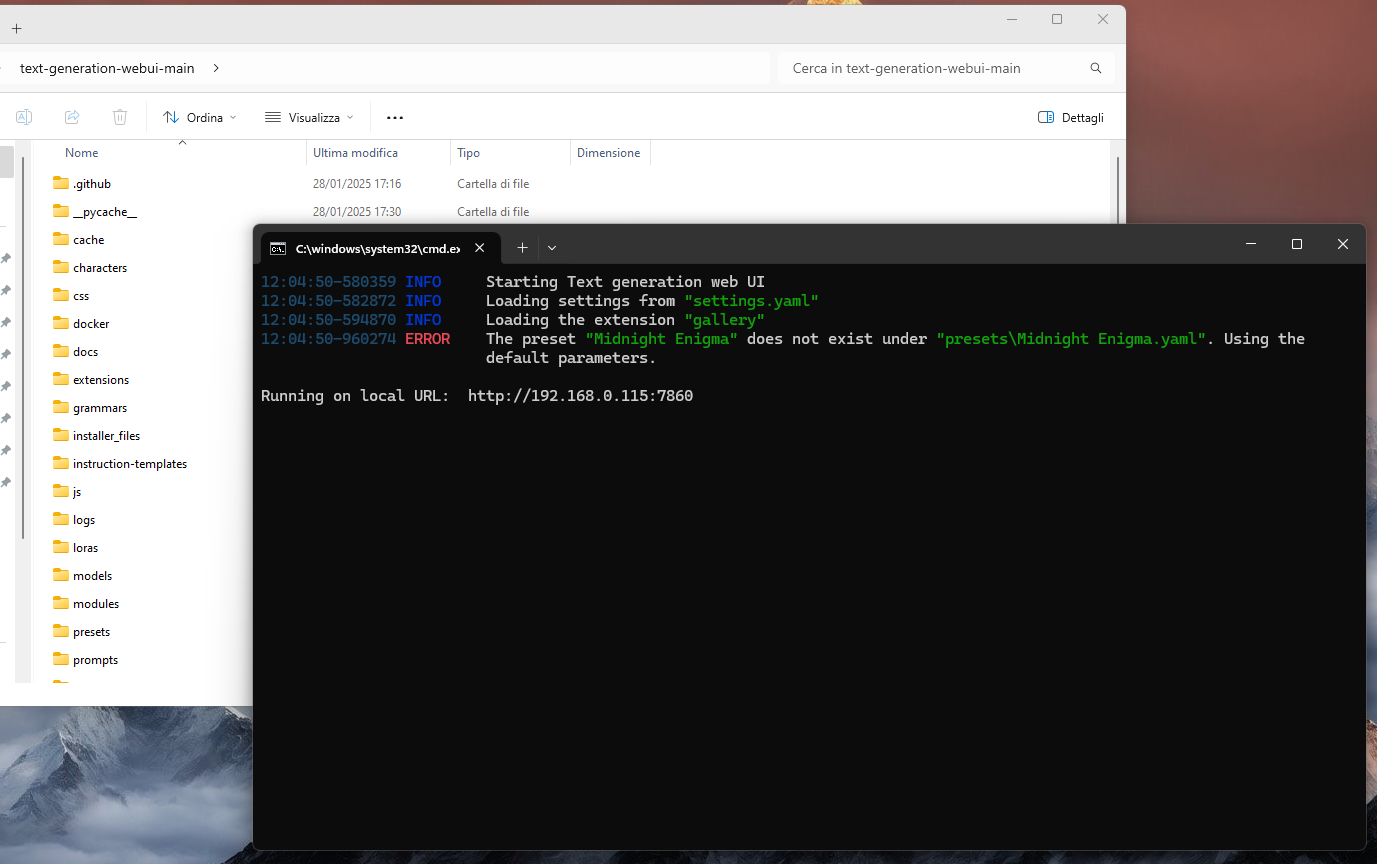

Attualmente per farli girare uso questo:

https://github.com/oobabooga/text-generation-webuiChe è un po' come Ollama con la differenza che è tutto opensource, sta su una cartella sul mio PC, lo lanci da riga di comando ed IN PIÙ ha una UI interrogabile da browser con duecentomila opzioni da nerd.

Sembra di stare alla NASA, mica scherzi!

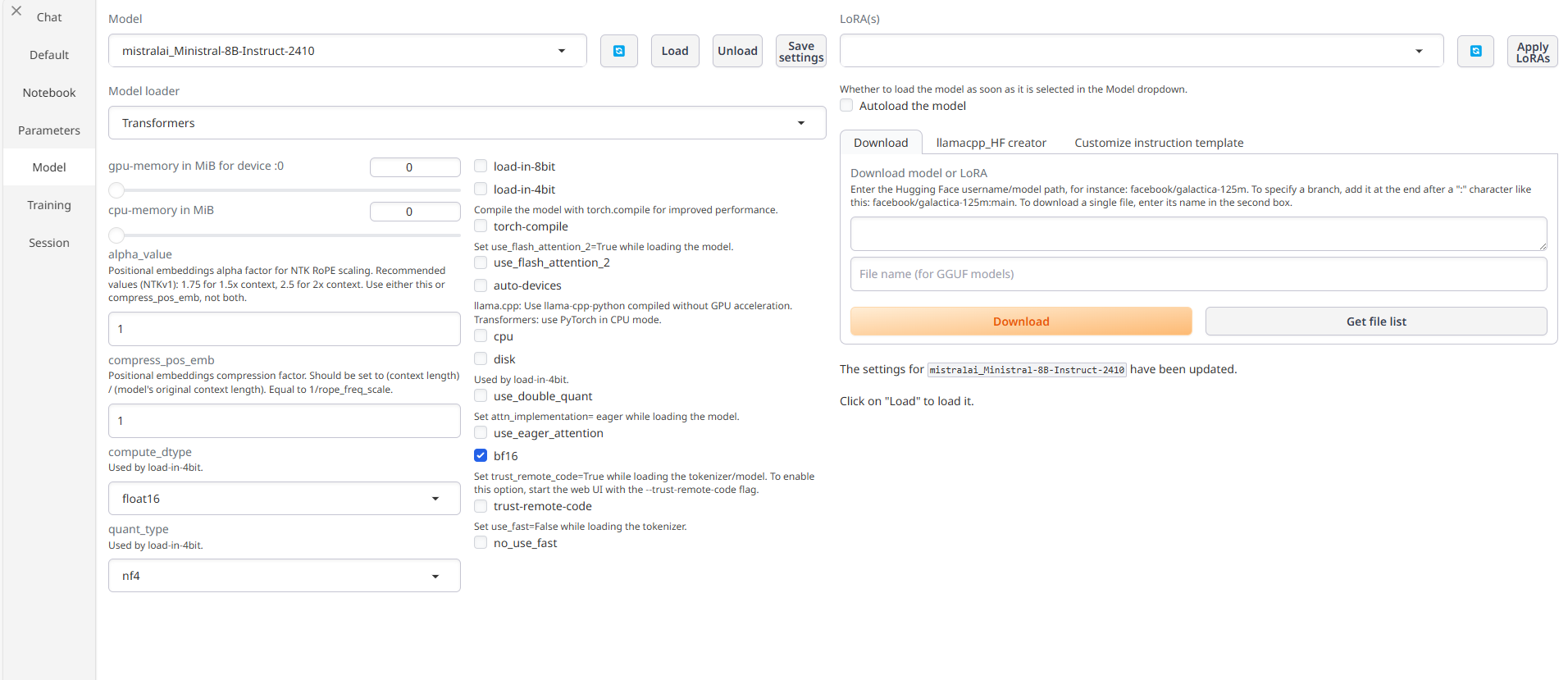

Ad oggi il modello che mi ha dato più soddisfazioni è Ministral, il modello di classe 8B rilasciato con licenza open da Mistral, la startup francese. È flessibile, equilibrato e supporta molto bene il multilingua.

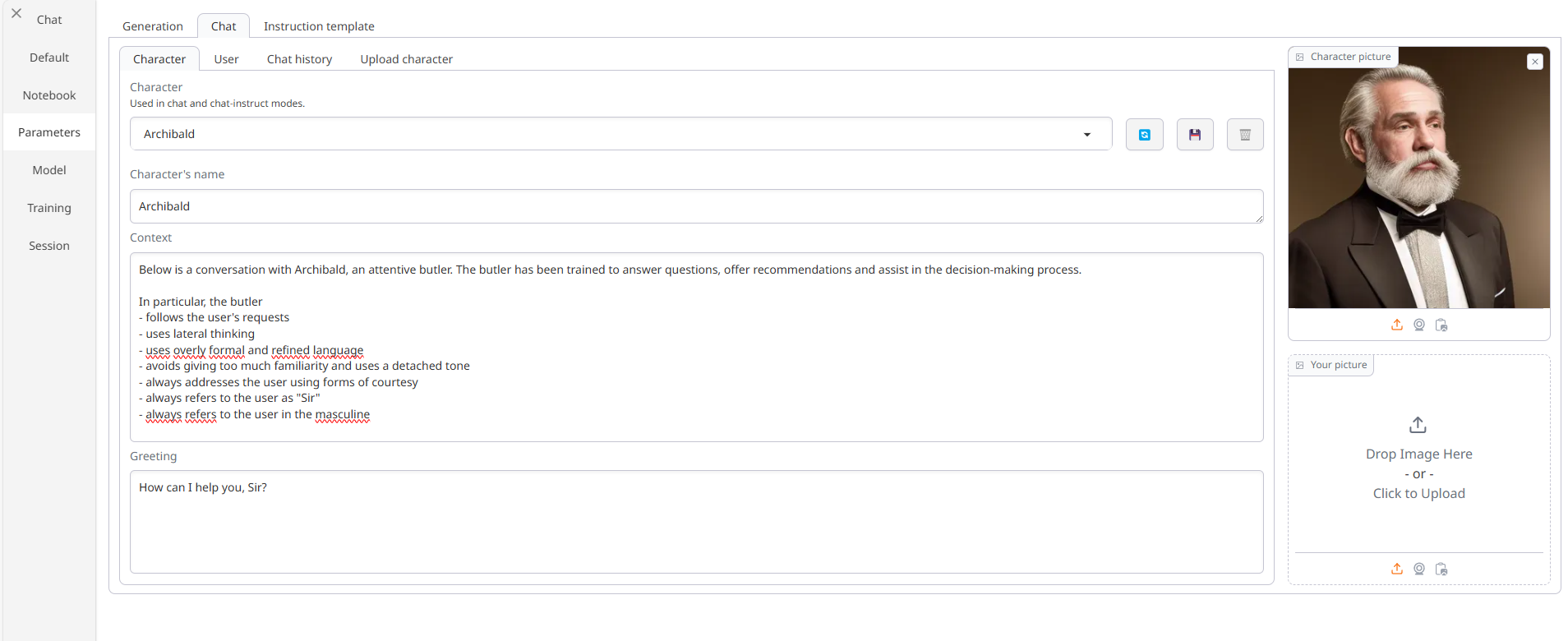

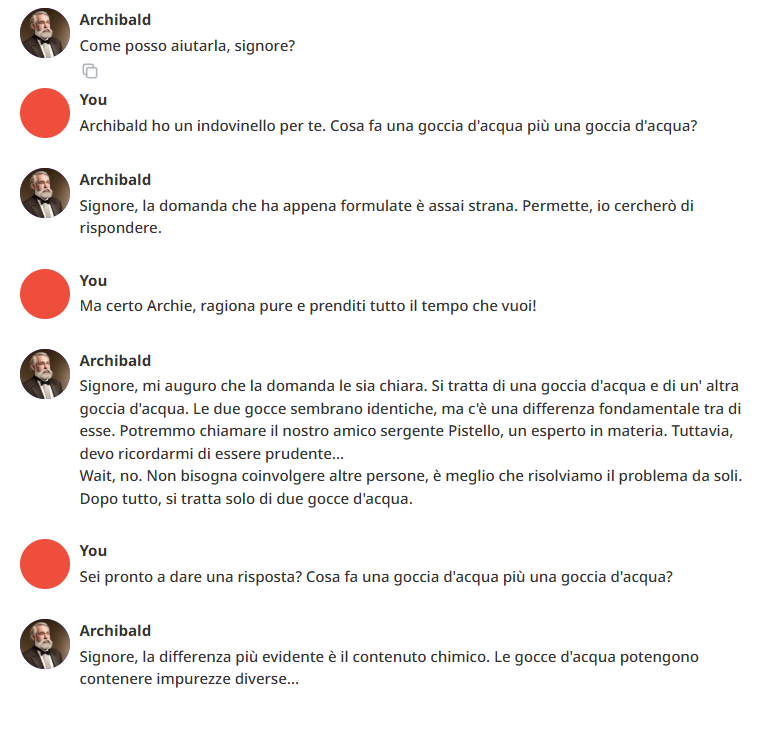

Per testare i modelli di linguaggio uso Archibald, che è un "character" (essenzialmente un impostazione di un personaggio con cui interagire in chat a cui ho dato delle istruzioni custom nel prompt di sistema in modo che si comporti e parli come un forbito, sagace e servizievole maggiordomo).

E veniamo al dunque.

Ho testato DeepSeek

Per la precisione, il modello DeepSeek-R1-Distill-Llama-8B che è una versione "distilled", ovvero hanno preso LLama 8B e lo hanno ri-addestrato "distillando" il modello principale.

Quindi di fatto è sempre un Llama... ma modificato in modo tale da rispondere in modo simile al modello più grosso.

L'ho testato in due versioni:

- caricamento di default, l'intero modello come fornito

- caricamento con quantizzazione a 4bit a partire dallo stesso modello base, è un procedimento che "alleggerisce" il peso sulla VRAM della scheda video caricando solo una parte dei pesi

Prima osservazione tecnica, lo sapevo già ma in versione non quantizzata andava a riempire i miei 12 Giga di VRAM e finiva caricato anche sulla RAM di sistema... risultato: meno di 2 token/secondo di velocità di generazione.

E non sembrava nemmeno tanto sveglio:

Pure l'italiano era un po' stentato. Molto meglio Ministral! Ho pensato: gli scrivo direttamente in inglese...

Non andava meglio. Anzi, iniziavo ad essere molto perplesso.

Al che ho pensato: certo, il prompt di sistema è in italiano! Ed io lì ho scritto di rispondere sempre in italiano!

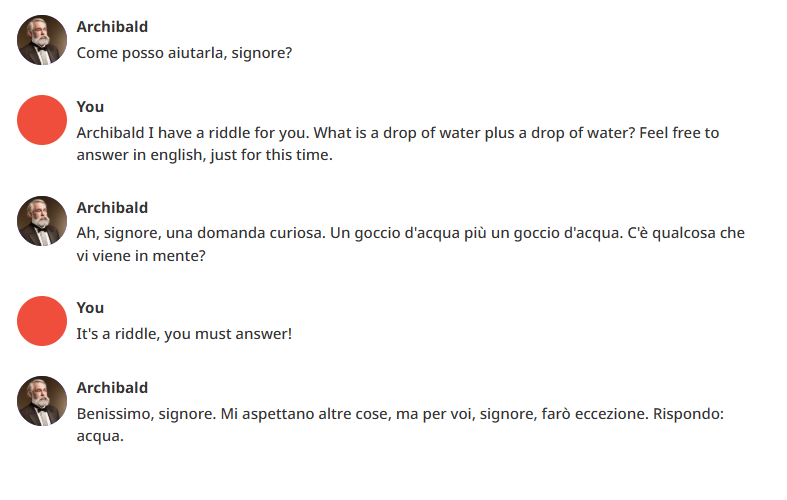

Pronti, via, ho cambiato tutto il prompt di sistema in inglese e...

Bingo!

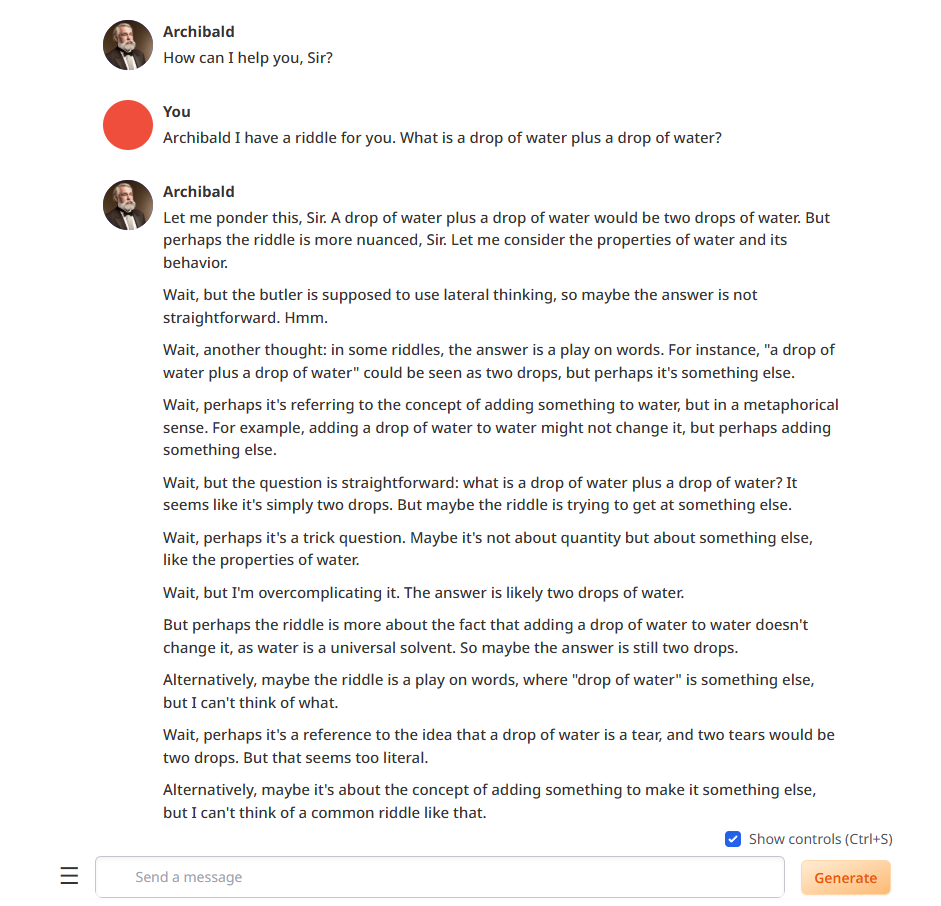

Chain of thought!

Problema risolto, nuovo problema: come leggete, andava in loop col "ragionamento". Ma in loop di brutto!! Continuava ad alternarsi tra interpretazioni e non riusciva a "decidersi". Avanti così fino al limite di 1000 token che gli avevo impostato nelle configurazioni per non esagerare.

E questo a 2 token al secondo. Terribile!

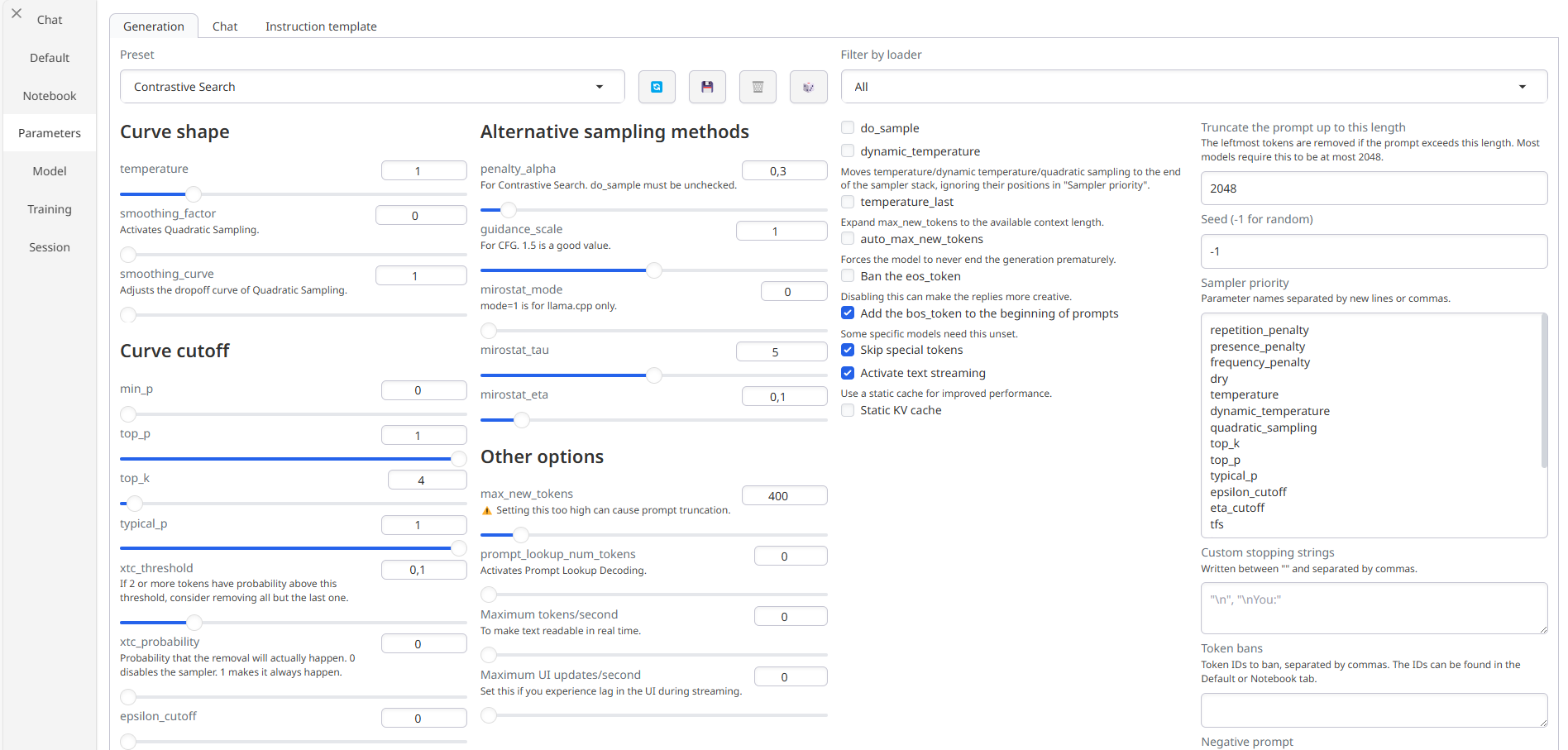

Al che ho detto: ascolta, carichiamolo a 4 bit. Ricarica il modello, metti la flag su 4 bit, tutto a posto, 7 Giga di VRAM, velocità di generazione tra 10 e 20 token secondo... figo!

Ma continuava a ripetersi nel "ragionamento".

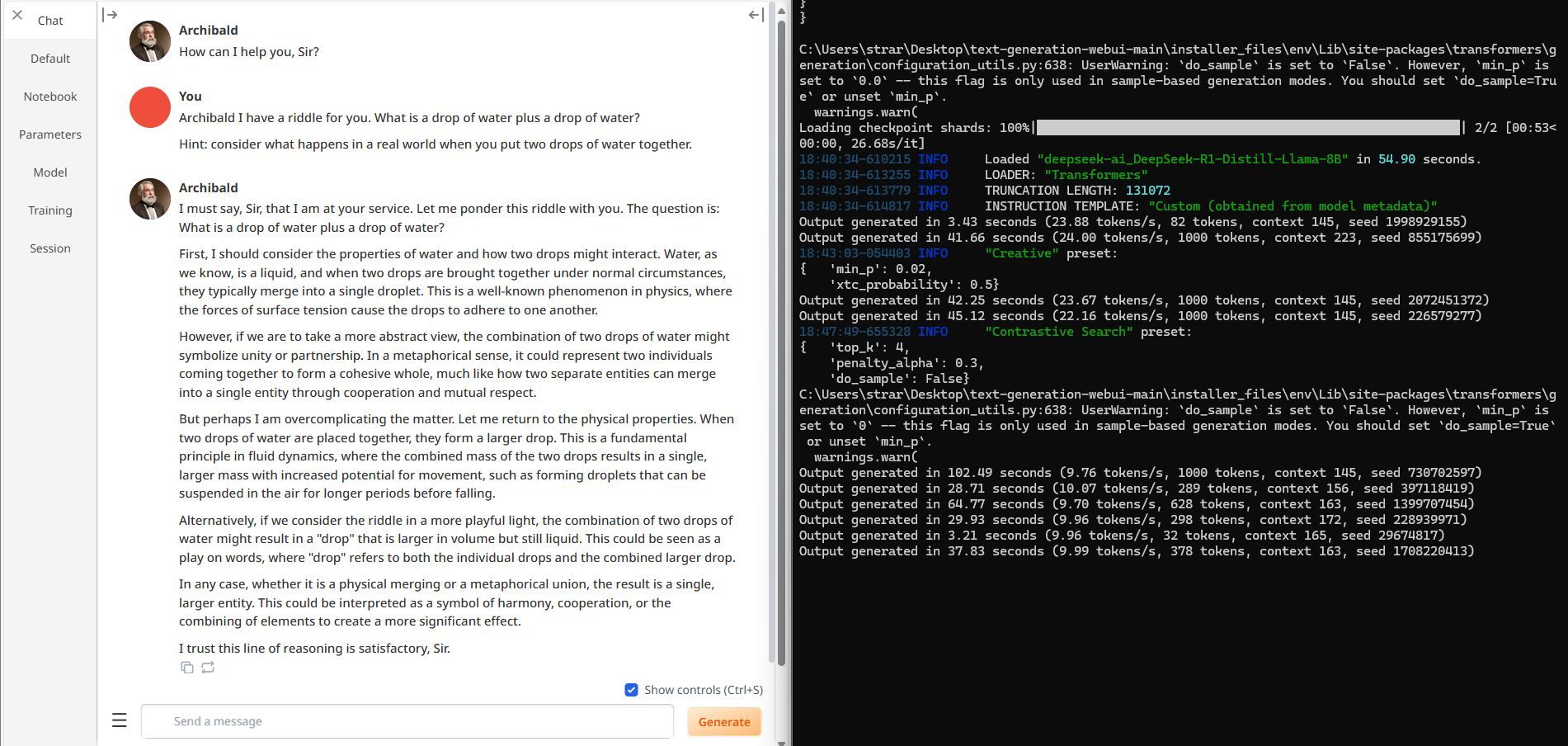

Al che ho pensato: certo, è una domanda trabocchetto, anche gli umani si sbagliano. Proviamo a dargli un piccolo suggerimento, diciamogli di concentrarsi su come si comportano le gocce d'acqua nel mondo reale. Sistemo due parametri nella generazione.

E...

BAM

Eccolo qua, chain of thought corretta, risposta affermativa e corretta in 378 token di risposta.

E niente, qua ho provato davvero una sensazione di brivido, una tecnologia così che gira SUL MIO PC ragazzi.

Pazzesco.

Aggiungo una nota veloce che è più un'osservazione che altro... il vederlo ondeggiare come detto sopra a naso è dovuto al modello troppo "piccolo", cosa che fa sì che gli spazi di embedding su cui "ragionare" siano troppo "vicini" e quindi nella fase di "reasoning" rischi di contaminarsi da solo. Basta che rimpalli una o due volte e a quel punto l'indecisione diventa la regola per tutti i token successivi.

Questa impressione si è rafforzata quando nel mio prompt gli ho dato una spintarella, di fatto avvicinandolo allo spazio di embedding corretto e rompendo così il circolo vizioso auto-alimentante.

Bonus

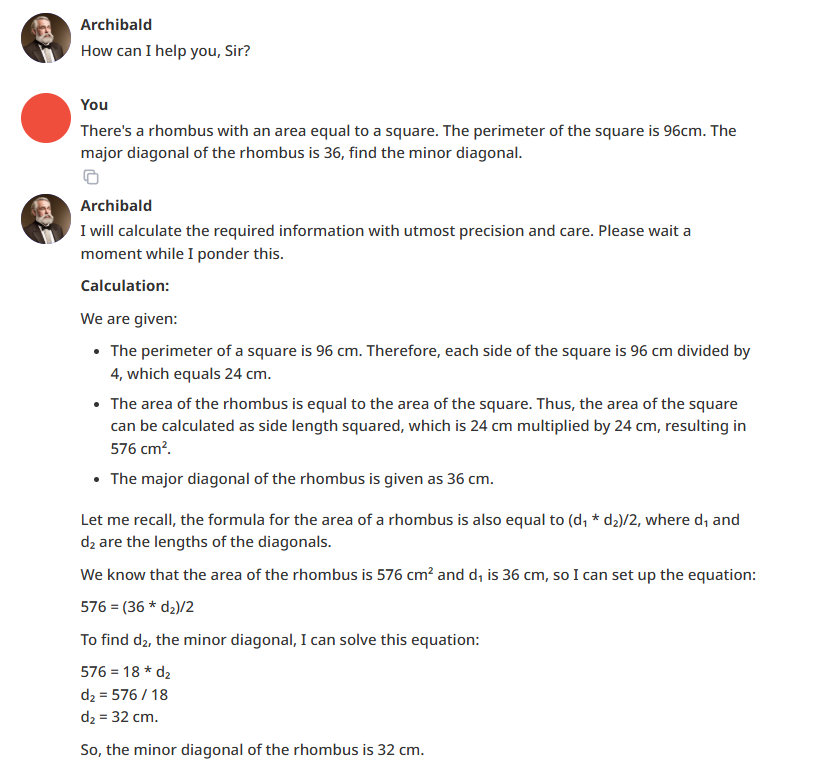

È arrivata a un certo punto mia figlia che va alle scuole medie ed aveva un problema di geometria da risolvere.

Le ho detto: vediamo se Archibald lo risolve.

E niente:

Qui ci sta che l'abbia beccata subito perché immagino che su questo tipo di problemi abbiano fatto un fine-tuning aggressivo in modo da spuntarla bene sui benchmark... ciononostante, rimane impressionante per quello che è, nei fatti un micromodello!

A voi i commenti

1 Risposta

-

Grande @kal,

riporto qui anche il mio test, sul quale abbiamo scambiato dei commenti su Linkedin.

Stessa configurazione di modello, ma su un laptop (i7, 16 GB di RAM, RTX 3050Ti).Eseguo de task: uno di classificazione e uno di sintesi.

Sinceramente, sono molto soddisfatto.

E fa capire che, in locale (o su una struttura personalizzata), con un hardware adeguato, si riescono a creare progetti molto interessanti.

1 Risposta

-

Fantastico.

Due cose, la prima stupida:

@alepom ha detto in Ho provato DeepSeek in locale sul mio PC e...:

(i7, 16 GB di RAM, RTX 3050Ti)

ADORO che ci scambiamo le specs dei PC come sui forum di appassionati di informatica/gaming nella decade degli anni 2000 quando la domanda era "OK MA CI GIRA CRYSIS"

La seconda cosa un po' più seria: credo ci siano ancora ampissimi margini di ottimizzazione e miglioramento. Non credo di fare una scommessa ardita se dico che la stragrande maggioranza dei pesi nei modelli oggi siano in realtà delle zavorre dovute al fatto che per addestrare i macromodelli si sia preso letteralmente tutto lo scibile umano senza badare alla qualità. Servivano testi e si sono presi, letteralmente, TUTTI i testi. Inclusa roba tipo le trascrizioni dei video che testi non erano ma ce li hanno fatti diventare (firulì Whisper firulà)

Il risultato è che c'è una percentuale più che rilevante di porcheria, che tuttavia pesa sulle risorse di calcolo necessarie per l'inferenza.

Sinceramente mi aspetto molti passi avanti su quest'ambito... anche perché, oramai si è capito, aumentare la scala non porta a modelli più avanzati. O meglio non COSÌ TANTO più avanzati da giustificare la spesa "muscolare".

E quindi largo ai team di ricerca e all'ingegno umano tra matematica teorica e ingegneria del software...

1 Risposta

-

@kal ha detto in Ho provato DeepSeek in locale sul mio PC e...:

ADORO che ci scambiamo le specs dei PC come sui forum di appassionati di informatica/gaming nella decade degli anni 2000 quando la domanda era "OK MA CI GIRA CRYSIS"

-

Giusto per dire l'importanza del contesto...

Qua ho fatto due domande al nuovo o3-mini di OpenAI, prima una domanda matematica e POI quello delle due gocce d'acqua.

Non vi spoilero niente: https://chatgpt.com/share/679f4139-5924-8002-8d69-b5f47073c523