Ok, a questa direi che possiamo anche credere.

Siete pronti ad aggiornare le quotazioni al rialzo?

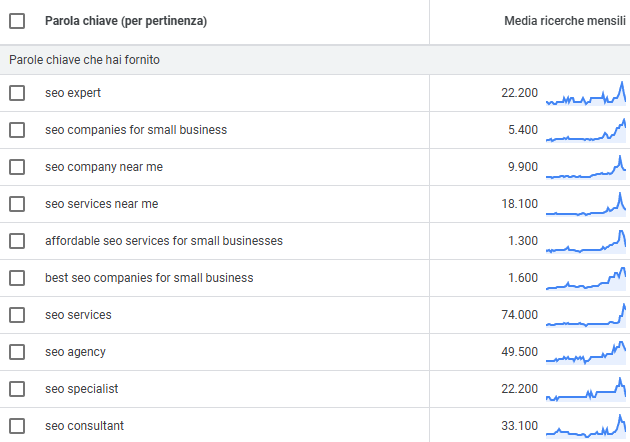

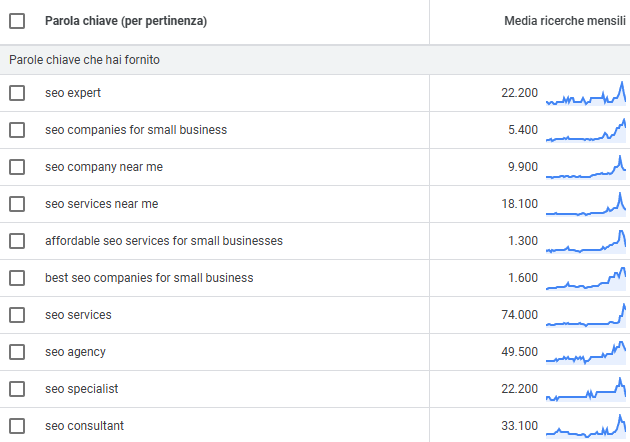

Perché non c'è neanche un modo in cui il mercato può assorbire un aumento della domanda come questo. Parliamo di un aumento del 200% su alcune query negli ultimi 3-4 mesi.

E no, neanche con gli assistenti LLM ad abilitare nuove schiere di improvvisati, che sono talmente esperti di SEO che ora si vendono come "GEO", termine che il mercato comunque non cerca (se non in modo del tutto marginale)!

Ora, detto chiaro: c'è una forte domanda di servizi "economici". Solo che la SEO fatta bene non è economica, richiede esperienza, ragionamento, strategia, visione di lungo periodo. Tutta roba costosa.

Scenario pratico: moltissime aziende si rivolgeranno innanzi tutto alla fascia bassa del mercato, quella abilitata dagli LLM (che esegue e non comprende davvero quello che sta facendo).

Finiranno scottati (perché sì, tutti noi che con gli LLM ci lavoriamo, sappiamo che verranno scottati e anche malamente...).

E poi chiameranno qualcuno per aggiustare