- Home

- Categorie

- Digital Marketing

- SEO

- Crawl Budget: quando effettivamente pensarci? Con più di 100.000 url

-

Crawl Budget: quando effettivamente pensarci? Con più di 100.000 url

Buon anno

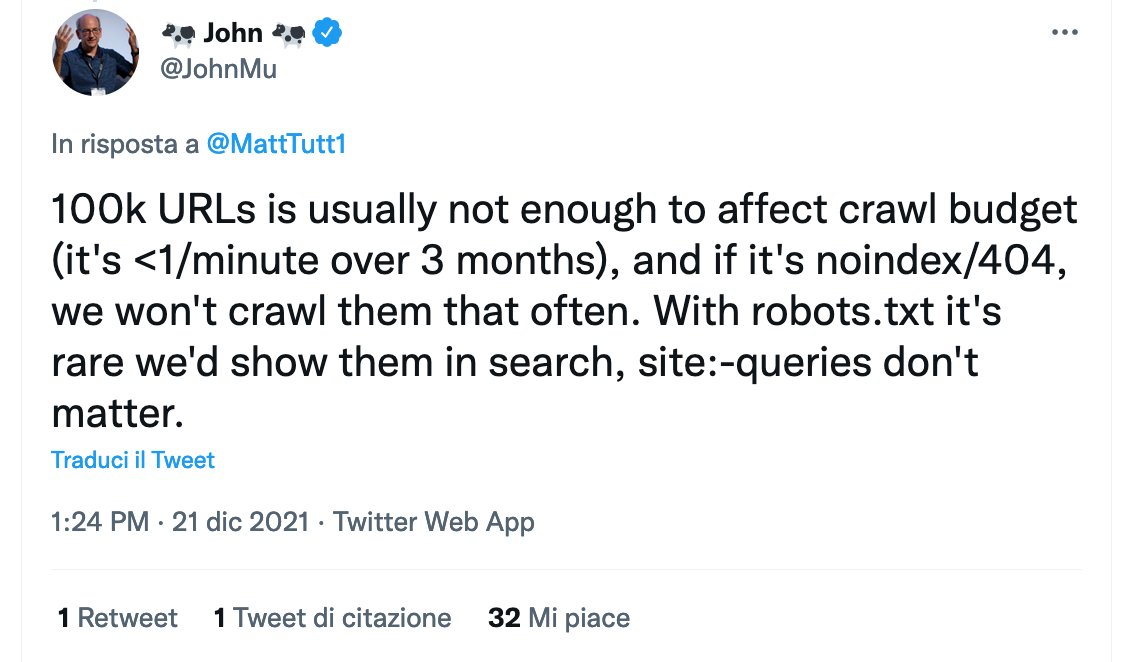

C'è una piccola curiosità che può interessare molti ed è in questo tweet di John Mueller

Vi consiglio la lettura per capire da dove parte la domanda e le risposte, perché la persona sta cercando di non far indicizzare risorse

-

Buon anno!

Come al solito in questi thread su Twitter ci sono ambiguità.

Ho l'impressione che la persona che ha posto la domanda dicesse di avere "100K URL di cacca (oltre a quelli buoni)", non di avere un sito di solo 100K URL. Per cui a quanto capisco il sito potrebbe averne molti di più, e John Mueller sarebbe stato allora un po' sbrigativo nel rispondere.

Anche l'affermazione "(it's <1/minute over 3 month)" non la trovo chiara per nulla.

Cosa avrà voluto dire?

Se intende dire di considerare una frequenza di crawl di un URL a minuto, conti alla mano per visitarne 100K ci vogliono sì 3 mesi, ma che c'entra?

Tre mesi possono non essere una preoccupazione per Google, ma come gestore di un sito di 100K URL - con una frequenza di crawl così lenta - un po' sull'ottimizzazione del crawl budget qualche pensiero ce lo farei eccome.Nota: l'articolo di Berry Schwartz su SEO Roundtable poi da per acquisito che il sito sia di soli 100K URL. Penso sia un fraintendimento.

2 Risposte

-

Ciao Federico,

mi accodo anche io, ho un sito con 100.000 Url e una frequenza di scansione di 8.000 pagine al giorno, questo significa che per scansionarlo tutto Google impiegherebbe 12 giorni, ma in realtà sono molti meno perchè ogni tanto (ogni 10 giorni circa) ci sono dei picchi di 20.000 o 30.000 pagine scansionate al giorno, questo non vuole essere un incentivo a disinteressarsi di ottimizzare il numero delle url ma che un sito fatto come si deve non ha questi problemi.

-

@federico-sasso ha detto in Crawl Budget: quando effettivamente pensarci? Con più di 100.000 url:

Tre mesi possono non essere una preoccupazione per Google, ma come gestore di un sito di 100K URL - con una frequenza di crawl così lenta - un po' sull'ottimizzazione del crawl budget qualche pensiero ce lo farei eccome.

Quoto. Ho giusto per le mani un sito con 5 versioni in lingua su terzi livelli differenti, ciascuna ha circa 7-8K pagine indicizzate e 20K pagine escluse.

La maggior parte sono escluse in quanto "rilevate ma non ancora indicizzate" oppure "scansionate ma non indicizzate".

C'è evidentemente un problema di crawl budget da risolvere, anche se per ciascun dominio siamo ben sotto alle 100K

-

Mi sono scontrato più volte con queste affermazioni* ma ritengo che la via della saggezza sia sempre la migliore, ovvero di pensare "se io fossi Google" che cosa farei, a prescindere dalle dimensioni del mio sito

È ovvio che se ho un sito di 50 pagine il problema probabilmente non si pone.

Il lato opposto è quando ti trovi un e-commerce di 5-6000 pagine reali che a causa di produttori malsani (dio mi fulmini da quanti ne ho visti negli ultimi 2 anni dai nomi più blasonati) che per mera ignoranza iniettano "inermi" bug e ti trovi degli indici da 2-3 milioni di pagine.Un altro punto che non si vuole capire è che ci sono fondamentalmente 2 report da guardare:

- report scansione Google e vedere sommariamente il flusso di googlebot

- log log log > a volte informazione inaccessibile o addirittura piattaforme in cloud che ti rispondono "raccogliamo solo un campione"

Io ritengo ovvio che il percorso che prepariamo noi per i motori sia lineare, senza labirinti, loop o perdite di tempo.

*ricordo che Google è quello che dice che in GSC nasconde solo alcune rare query e che raro corrisponde a 40%, osservazione più volte mossa su Twitter e a cui né John né Sullivan hanno mai risposto!!!