- Home

- Categorie

- Digital Marketing

- SEO

- Helpful content update

-

In ogni caso in questo momento non ci sono stati grandi sconvolgimenti dichiarati in lingua inglese.

Almeno per ora.Forse non sono neanche tanto convinti quelli di Google, visto che hanno lasciato un modulo per segnalare eventuali anomalie: https://docs.google.com/forms/d/e/1FAIpQLSfiHK67MSjwH8U_dt-DFiMaT-Gp4IGxUmgzBGQcbgR-PQBpEA/viewform

e per addestrare meglio il modello.Forse anche memori di altri algoritmi che hanno avuto un numero elevato di falsi positivi e falsi negativi, abbassandone la qualità complessiva.

-

Che l'eliminazione dei contenuti inutili, trascurati ed esplicitamente creati per i motori di ricerca, fosse una pratica SEO sottovalutatissima ne sono sempre stato convinto. Diciamo che non è esattamente una gran novità.

Personalmente leggo questa mossa di G anche come un tentativo per disincentivare dalla creazione di contenuti autogenerati tramite software di AI i quali, in pochissimo tempo, hanno preso il sopravvento.

1 Risposta

-

@minichiello io personalmente non credo e non ho mai creduto nella capacità di Google di discernere contenuti umani da automatici.

Lo dicevo al secondo convegno e ne sono pienamente convinto. Infatti funzionano ancora alla grande testi spinnati senza nessun bisogno di ricorrere all'AI che a mio modesto parere è l'ennesimo termine che i venditori di fumo usano per propinare la solita fuffa con un termine di tendenza.

-

Allora, vorrei fare chiarezza sulla questione AI, perché mi rendo conto che sta sfuggendo enormemente di mano. E grazie @juanin per aver già iniziato con il tuo post.

Ho commentato anche Search Engine Roundtable stamattina infuriato.Partiamo dal concetto di "Correlation is not causation": dobbiamo farcelo entrare in testa. Il post di Search Engine Roundtable afferma che tra i colpiti ci sono siti web con contenuti generati dall'AI.

I testi scritti usando l'AI hanno qualità inferiore se sono inutili: esattamente come se li avesse scritti un essere umano.

Forse il concetto è diverso.. forse stiamo dicendo che la maggior parte dei siti in cui si è usata l'AI sono spazzatura.. ma in questo l'AI non c'entra nulla.

Gli algoritmi non prendono pezzi qua e là: generano contenuti originali, e non sono riconoscibili da quelli di un essere umano. C'è chi scrive molto peggio e non è definito un'AI

Come potrebbe un algoritmo riconoscere un testo generato in modo probabilistico da un algoritmo partendo da un prompt inimmaginabile? E magari con un training aggiuntivo non simulabile?

Come potrebbe un algoritmo riconoscere un testo generato in modo probabilistico da un algoritmo partendo da un prompt inimmaginabile? E magari con un training aggiuntivo non simulabile?

Immaginiamo, inoltre, se viene fatto un rework da un copy dei testi generati da un algoritmo!Quindi, basta divulgare concetti per "sentito dire": I CONCETTI VANNO STUDIATI E COMPRESI. E I DATI VANNO CONTESTUALIZZATI.

2 Risposte

-

Quoto in toto @alepom e aggiungo rispetto al mio commento che non ho nessun problema con l'AI.

Ho un problema con chi spaccia per AI 3 IF THEN ELSE su software che promettono miracoli quando invece hanno ancora linee di codice di quando l'AI neanche esisteva

Insomma ci siamo capiti.

E comunque ci sono molte persone che scrivono peggio anche di text spinner quindi ...

-

Mi sembra di capire che chi realizza contenuti prestando attenzione all'utente, alla grammatica, all'ortografia e all'argomento, viene sempre premiato? Fin qui nulla di nuovo.

Tuttavia ancora non mi è chiaro come valuta Google gli articoli datati dei magazine.

Non ho esperienza di contenuti IA, tuttavia mi piacerebbe capire se davvero siano così simili a quelli prodotti da "umani".

-

@alepom ha detto in Helpful content update:

Gli algoritmi non prendono pezzi qua e là: generano contenuti originali, e non sono riconoscibili da quelli di un essere umano. C'è chi scrive molto peggio e non è definito un'AI

Come potrebbe un algoritmo riconoscere un testo generato in modo probabilistico da un algoritmo partendo da un prompt inimmaginabile? E magari con un training aggiuntivo non simulabile?

Come potrebbe un algoritmo riconoscere un testo generato in modo probabilistico da un algoritmo partendo da un prompt inimmaginabile? E magari con un training aggiuntivo non simulabile?Per gli umani c'è un modo per riconoscere contenuto prodotto da una "persona": lo stile. Prendiamo il caso di una "penna" di un giornale: il giornalista ha un suo stile, quasi sempre riconoscibile e originale.

1 Risposta

-

@annabruno diciamo che potenzialmente anche un'AI può avere un suo stile se applichi un training che la conduce ad avere un certo stile.

-

Quindi? Alla fine quali sarebbero questi famosi contenuti spazzatura? Come li riconoscete voi e come li riconosce Google?

Poi? Una volta individuati? Che faccio, cancello l'articolo? Redirect? Che ne pensate?

@giorgiotave se ripassi per Monte Mario fammi un fischio ci prendiamo un caffè!

1 Risposta

-

@giulio06 i contenuti spazzatura devi sapere tu quali sono. Non te lo può dire nessuno.

1 Risposta

-

@juanin beh si certo, volevo sapere poi una volta individuati che fate

1 Risposta

-

@giulio06 se è spazzatura la cosa facile è piazzare un 410 e rimuovere ogni riferimento a quella pagina dall'architettura informativa.

Se invece ha tonnellate di link buoni (cosa però improbabile visto che dovrebbe essere spazzatura) allora puoi fare un 301 verso il contenuto buono più affine possibile alla tematica.

-

@juanin ha detto in Helpful content update:

pazzatura la cosa facile è piazzare un 410 e rimuovere ogni riferimento a quella pagina dall'architettura informativa.

Se invece ha tonnellate di link buoni (cosa però improbabile visto che dovrebbe essere spazzatura) allora puoi fare un 301 verso il contenuto buono più affine possibile alla tematica.molto bene grazie!

-

Io comunque li aspetto al varco...

anche questo update sarà un bluff. Se ci fosse la possibilità di scommetterci lo farei.

-

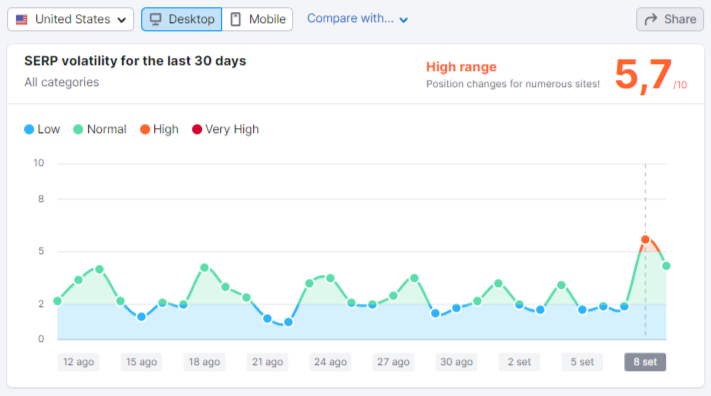

Ieri scadevano le due settimane dal lancio dell'update, e nelle serp americane c'è stato un po' di movimento.

-

@claudio-braccianti ha detto in Helpful content update:

Contenuti del blog non centrati a pieno con il core del sito

Contenuti blog che non fanno visite da organico (mettendo 'noindex')?

Pagine categorie/prodotti/product list che non fanno visite da organico (mettendo 'noindex')?No a tutte e tre le cose.

SE impatta (vediamo come), sono da levare i contenuti fuffa. Quelli che hai messo solo per gonfiare il text-to-html ratio o altre cavolate del genere.

O per dirla in termini ancora più semplici... il "testo SEO".

Se hai messo sul tuo sito un "testo SEO", probabilmente sei a rischio.

Però ripeto: vediamo QUANTO.

Perché inizio ad avere la sensazione che, come del resto per tutti gli update annunciati in anticipo, sia in realtà molto meno impattante di quanto temuto.

È anche vero che potrebbe essere una prima versione e altre seguiranno...

(del resto fu la stessa cosa anche con Panda e Penguin...)

-

Anche se non sono un esperto vorrei dire la mia. I contenuti scritti dall'intelligenza artificiale si riconoscono da un chilometro se non vengono corretti da una persona e alla fine si impiega di più a correggere e capire se quello riportato dall'AI è giusto o sbagliato che a scrivere un articolo da zero. Troppe inesattezze a seconda dell'argomento (praticamente tutti), paragrafi corti, alcune cose scritte non hanno senso, contenuti che non seguono un filo logico tra un paragrafo e l'altro. Se vuoi scrivere qualcosa di tecnico come una guida su un PC è meglio lasciare perdere, ma se vuoi scrivere qualcosa su come pulire un paio di occhiali o su una dieta è forse più facile ottenere un testo un po' più decente ma che necessita sempre di correzioni. Vogliamo parlare poi dei siti con 1000 domande e risposte (PAA) e che copiano i contenuti direttamente da Google e che a sua volta li estrapola dai siti? Ma quanto ci vorrà per un algoritmo per scovare un sito del genere?

Eppure questa è la conferma che Google non ha rilasciato un buon aggiornamento. "number of eyes horse? 9"

https://www.google.com/search?q=number+of+eyes+horse

"Q: How many eyes does a horse have? A: Nine. The equine eye contains two balls and a thin slit that closes when the horse is frightened."Penso poi che l'ultimo aggiornamento sia più che altro per i testi in lingua inglese perché è proprio in questa lingua che si notano maggiormente questi siti automatizzati e che pubblicano tonnellate di contenuti creati con l'intelligenza artificiale e che sono praticamente spazzatura, ma con Adsense attivo (e già da qui senza algoritmi, dal team Google potrebbero capire in che razza di siti vengono pubblicati i loro banner).

In Italia non ho visto ancora nulla che possa porre all'attenzione Google, forse perché i software per scrivere i testi con l'AI sono "ottimizzati" per l'inglese e quelli che provano a generare un testo in italiano fanno più pena della pena possibile immaginabile. Ne ho già provato un bel paio di software AI e alcuni più di altri sono praticamente truffe per spennare soldi e fanno perdere tempo e basta. Magari qualcuno non sarà d'accordo ma questa è la mia esperienza. Meglio scrivere a mano almeno per ora.

1 Risposta

-

Non lavoro per OpenAI, sia chiaro

, però non basta aprire l'interfaccina web si qualche servizio online, scrivere due righe e pretendere magie.

, però non basta aprire l'interfaccina web si qualche servizio online, scrivere due righe e pretendere magie.Serve capire il mezzo, capire dove può essere utile, capire come può essere utile (NON FA TUTTO PER TUTTO). Questo implica test nel trovare il prompt giusto per determinati output (anche usando automazioni per generare esempi esaustivi per il completamento) e sviluppo (paragrafi corti... ma il modo di allungarli c'è, però serve studiare, leggere la documentazione, testare i parametri e i prompt).

In realtà, considerando gli aspetti che ho appena descritto, si possono ottenete buoni risultati con risparmio di effort. Però ho usato anche prompt da oltre 300 parole (generati dinamicamente) per generare delle descrizioni ben fatte per dei prodotti.

E ricordiamoci che miglioreranno.

Comunque siamo OT alla grande

1 Risposta