grazie per i consigli. Ho già provveduto a contattare il moderatore

- Home

- raffaele80it

- Post

raffaele80it

@raffaele80it

Post creati da raffaele80it

-

RE: Aiuto per migliorare posizionamento organicopostato in SEO

-

RE: Aiuto per migliorare posizionamento organicopostato in SEO

quale strumento potrei utilizzare per rilevare questo Warning: Unknown: open( ?

-

RE: Aiuto per migliorare posizionamento organicopostato in SEO

volevo modificare il post per togliere i link attivi ma non riesce a trovare un link su cui cliccare per modificare il messaggio

-

Aiuto per migliorare posizionamento organicopostato in SEO

Ciao a tutti,

sto avendo un po' di difficoltà a portare 9 pagine del mio sito da top 20 a top 10. Purtroppo non si tratta di pagine di articoli (dove già qualche obiettivo l'ho raggiunto) ma di pagine che mostrano risultati di ricerca. Riporto di seguito l'elenco delle pagine con ciascuna keyword corrispondente.

Grazie in anticipo a chi vorrà darmi qualche consiglio o semplicemente confrontarsi

[TABLE="width: 0"]

[TD]keyword[/TD]

[TD]URL[/TD]

[TD="align: center"]posizione attuale[/TD]

[/TR][TD]case vacanze ispica mare[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/ispica_mare[/TD]

[TD="align: center"]5[/TD]

[/TR][TD]case vacanze scoglitti[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/scoglitti[/TD]

[TD="align: center"]8[/TD]

[/TR][TD]case vacanze sicilia animali ammessi[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/servizi-animali_domestici_ammessi[/TD]

[TD="align: center"]8[/TD]

[/TR][TD]case vacanze granelli pachino[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/zone-granelli,morghella,pachino_centro[/TD]

[TD="align: center"]9[/TD]

[/TR][TD]case vacanze portopalo[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/portopalo_di_capo_passero[/TD]

[TD="align: center"]10[/TD]

[/TR][TD]case vacanze pachino[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/pachino_mare[/TD]

[TD="align: center"]10[/TD]

[/TR][TD][/TD]

[TD][/TD]

[TD="align: center"][/TD]

[/TR][TD]casa vacanze san lorenzo marzamemi[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/zone-spinazza,lido_di_marzamemi,bove_marino,marzamemi_centro,san_lorenzo[/TD]

[TD="align: center"]12[/TD]

[/TR][TD]case vacanze marzamemi[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/marzamemi[/TD]

[TD="align: center"]15[/TD]

[/TR][TD]casa vacanze noto marina[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/noto_mare[/TD]

[TD="align: center"]17[/TD]

[/TR][TD]case vacanze avola mare[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/avola_mare[/TD]

[TD="align: center"]20[/TD]

[/TR][TD]case vacanze sicilia mare[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare[/TD]

[TD="align: center"]20[/TD]

[/TR][TD]case vacanze ragusa mare[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/ragusa_mare[/TD]

[TD="align: center"]24[/TD]

[/TR][TD]casa vacanze lido di noto[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/noto_mare[/TD]

[TD="align: center"]31[/TD]

[/TR][TD]affitti case vacanze sicilia[/TD]

[TD]https://www.soluzionivacanze.com/[/TD]

[TD="align: center"]36[/TD]

[/TR][TD]case vacanza pozzallo[/TD]

[TD]https://www.soluzionivacanze.com/it/case_vacanze_sicilia_mare/pozzallo[/TD]

[TD="align: center"]42[/TD]

[/TR]

[/TABLE] -

RE: recaptcha v2 invisible e mail spazzaturapostato in Coding

aggiorno:

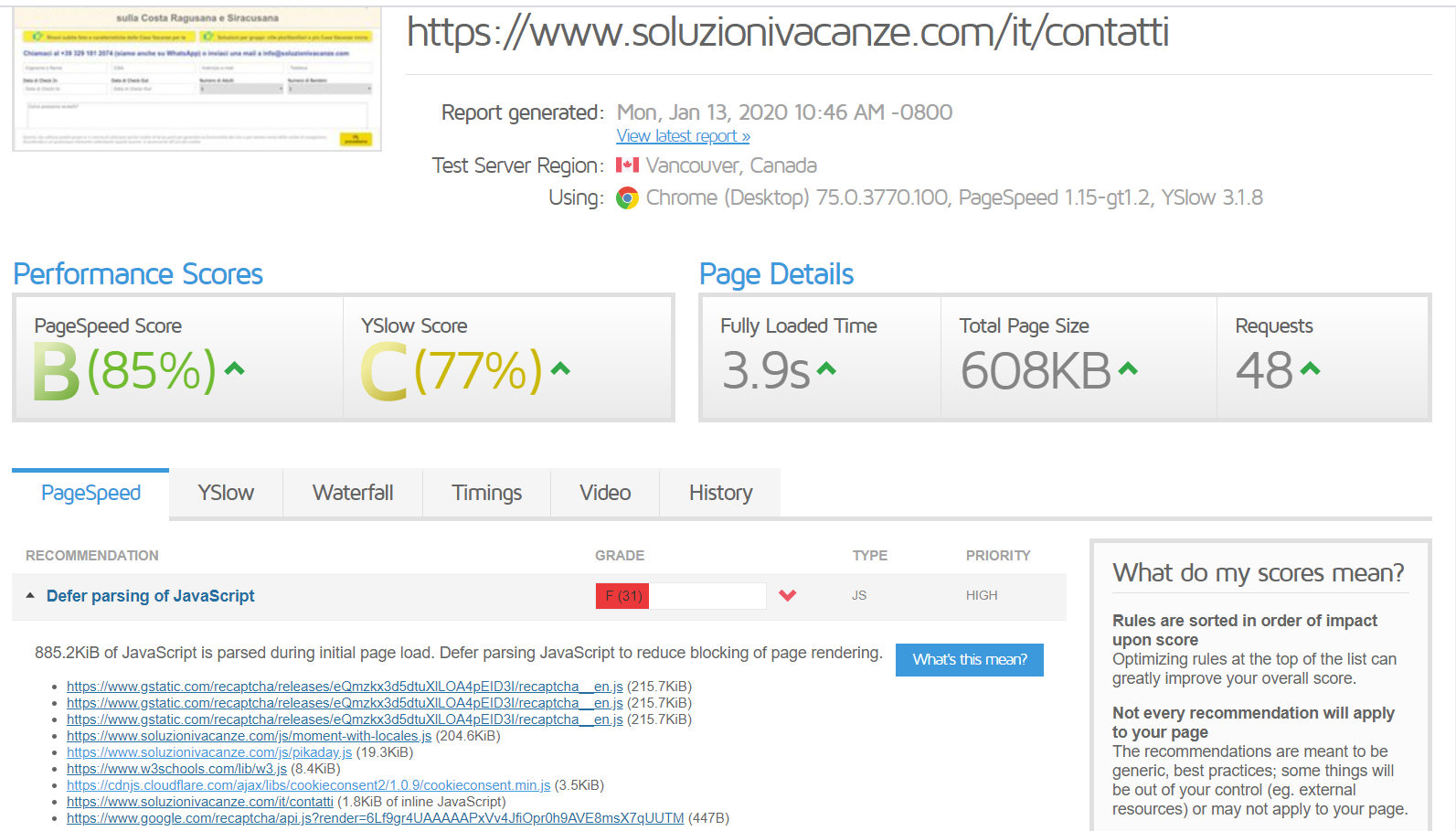

alla fine ho deciso di mettere il recaptcha sono nella pagina contatti (https://www.soluzionivacanze.com/it/contatti) ma sto notando la presenza di più volte la stessa URL su “deferparsing javascript”.

Come potrei risolvere?

-

RE: recaptcha v2 invisible e mail spazzaturapostato in Coding

Grazie Davide,

in effetti non avevo configurato bene. Spero adesso funzioni.

Magari se ho ancora problemi aggiorno.

Grazie mille -

recaptcha v2 invisible e mail spazzaturapostato in Coding

Ho installato sul mio sito recaptcha v2 invisible come descritto nella guida ufficiale al paragrafo "automatically bind the challenge to a button": https://developers.google.com/recaptcha/docs/invisible

Tutto funziona ma ricevo sempre mail spazzatura.

Avete mai avuto questo problema? -

analisi di access.log per ottimizzazione del crawl budgetpostato in SEO

Ciao a tutti,

analizzando access.log mi sono accortogoogle continua a scansionare anche URL non più presenti nel proprioindice.

Facendo dei test a campione ho vistoche in molte queste URL vi sono dei chain redirect.

Secondo voi vale la pena di correggerlioppure questa operazione va limitata solo agli URL importanti delsito già indicizzati e posizionati? -

RE: analisi di access.logpostato in SEO

se è per quello non c'è problema: il sito è sempre in continuo aggiornamento

-

RE: analisi di access.logpostato in SEO

già contattato. Mi hanno dato questa risposta:

Gentile Cliente,trattandosi di IP non appartenenti ai sistemi di controllo di OVH, a meno che lei non riconosca quei due IP come appartenenti a qualche servizio che le serve, le suggerisco di implementare apposite regole sul firewall network del VPS, perché potrebbe trattarsi di tentativi di accesso fraudolento:

docs.ovh_com/it/dedicated/firewall-network/In pratica c'è una piattaforma che permette di impostare delle regole.

Qualcuno saprebbe darmi qualche consiglio su come devo compilare questo form? -

RE: analisi di access.logpostato in SEO

inoltre registro 2463 eventi da ecs-119-3-233-30.compute.hwclouds-dns.com

-

analisi di access.logpostato in SEO

Ciao a tutti,

sto utilizzando Splunk per provare a fare un'analisi di access.log. Fra le 9 e le 10 di stamattina rilevo 1486 eventi da parte di "no-reverse-dns-configured.com", tutti restituenti 404.

Devo preoccuparmi?

Dominio:

soluzionivacanze.com

Motori:

Google

Prima indicizzazione o attività:

2012

Cambiamenti effettuati:

nell'ultimo mese nessuno

Eventi legati ai link:

aumento di visite, miglioramento del posizionamento

Sito realizzato con:

codice php e html. No cms

Come ho aumentato la popolarità:

ottimizzazione struttura url, alleggerimento pagine, backlink interna, analisi query di ricerca e relativa ottimizzazione dei contenuti

Chiavi:

non necessarie per il quesito

Sitemaps:

Si -

RE: Riscrittura degli URL a seguito di revisione struttura sitopostato in SEO

Ciao, confermo che i nuovi URL hanno rimpiazzato quelli vecchi, acquisendone anche il posizionamento. Tutto okj quindi.

Grazie e a presto -

RE: Riscrittura degli URL a seguito di revisione struttura sitopostato in SEO

Ciao a tutti,

circa 10 giorni fa ho terminato di eseguire tutti i redirect 301 e ho lasciato nella sitemap sia i vecchi che i nuovi url.

Al momento i nuovi url sono stati indicizzati (ho verificato con il comando site:url)Da un paio di giorni però molte delle url importanti, che erano posizionate per keyword specifiche, sono sparite dalle SERP. Mi spiego meglio:

prima del redirect 301, per una determinata keyword, il vecchio URL era posizionato alla 22esima posizione.

Adesso, cioè dopo il redirect 301, per quella stessa keyword, l'URL nuovo non è posizionato (nelle SERP non appare nè quello vecchio nè quello nuovo).E' solo una questione di attendere oppure c'è qualche problema?

Grazie in anticipo

Daniele -

RE: Il Rel Prev e Next: Google non lo supporta da annipostato in SEO

Grazie mille Federico per la tempestiva risposta.

@Federico Sasso said:

Vuoi che le pagine risultato siano indicizzate?

Google non ama restituire nei propri risultati di ricerca dei risultati di ricerca di altri, la considera una povera esperienza utente, ma ci sono casi in cui ha senso farlo. Per esempio se le pagine di risultato sono il normale metodo di navigazione del sito.Ti confermo che la visualizzazione dei risultati di ricerca è il normale metodo di navigazione del sito. Queste pagine contengono infatti parecchi filtri da utilizzare per consentire agli utenti di trovare la sistemazione più adatta alle proprie necessità.

Gli url importanti del sito sono proprio alcune pagine di risultati di ricerca. Si tratta di circa 11 specifiche url, ovviamente non parametrate.

Le URL parametrate sono messe in disallow.@Federico Sasso said:

Le pagine foglia con i dettagli delle appartamenti hanno dei percorsi di esplorazione che permettono allo spider di raggiungerle (al di là della pagina di risultato)?

Perché se così non fosse mettendo le pagine di risultato successive alla prima in Disallow impediresti allo spider al motore di ricerca di indicizzare e posizionarle le pagine di dettaglio.Si, allo stato attuale le pagine di risultato successive alla prima sono messe in Disallow e sto capendo che in tal modo i link delle pagine foglia presenti nelle pagine di risultato successive alla prima non possono essere "crawlate".

Le pagine foglia con il dettaglio di ogni singola sistemazione, i cui link sono contenuti nelle pagine di ricerca, ho deciso di metterle in noindex, follow per due motivi:- dare più forza alle "importanti" pagine di ricerca;

- non avrebbe senso posizionare le pagine foglia poiché, essendo molto simili fra loro, competerebbero per le stesse keyword cannibalizzandosi tra di loro.

In particolare, ho una pagina che restituisce 108 risultati di ricerca. Allo stato attuale, così come tutte le altre, è suddivisa in più pagine ciascuna contenente 10 risultati di ricerca e le pagine successive alla prima sono disallowate.

Come potrei comportarmi?

Devo lasciare la paginazione attuale ed inserire i markup rel e next, togliendo anche il disallow alle pagine successive alla prima?

Oppure sarebbe meglio mostrarla come pagina unica con conseguenze però negative sul loadtime?Sinceramente sono un po' confuso :bho:

Avrei proprio bisogno di qualche dritta

Ringrazio in anticipo

-

RE: Il Rel Prev e Next: Google non lo supporta da annipostato in SEO

Ciao a tutti,

ho notato la presenza di varie correnti di pensiero sull'utilizzo del Rel Prev e Next e stavo cercando qualche dritta per il mio sito.

Premetto che non ho mai utilizzato il Rel Prev e Next.

La pagina in esame, che utilizzo anche come landing page, restituisce 27 risultati di ricerca suddivisi i n 3 pagine: soluzionivacanzePUNTOcom/it/case_vacanze_sicilia_mare/marzamemi

Allo stato attuale le pagine successive alla prima, essendo URL parametrate, sono "disallowate" da robots.txt e google ovviamente posiziona solo la prima pagina con i suoi 10 risultati di ricerca.

Mi chiedevo se tale pratica è corretta oppure sarebbe meglio consentire (allow) al crawler di scansionare anche le pagine successive alla prima, servendole magari come:soluzionivacanzePUNTOcom/it/case_vacanze_sicilia_mare/marzamemi?page=2

soluzionivacanzePUNTOcom/it/case_vacanze_sicilia_mare/marzamemi?page=3In tal caso, utilizzando il Rel Prev e Next, otterrei dei benefici in termini di posizionamento della prima pagina?

Nel caso in cui invece non volessi utilizzare il il Rel Prev e Next, qualè la best practice corretta?

Grazie in anticipo.

Daniele -

RE: Robots.txt e file PDFpostato in SEO

Utilissimo, grazie mille.

Almeno adesso so di avere un problema meno.

A presto

-

Robots.txt e file PDFpostato in SEO

Ciao a tutti,

al fine di ottimizzare al meglio il crawl budget, mi chiedevo se è utile far scansione al crawler i link ai file PDF presenti nelle pagine, come ad esempio questa: soluzionivacanze.com_slash_it_slash_pagine_slash_faqil link al file pdf presente in tale pagina è il seguente: soluzionivacanze.com_slash_html_slash_testi_termini_it.pdf

Da un lato, penso che mettendola in disallow si risparmi crawl budget, dall'altro, temo che la mancata scansione possa far ridurre, agli occhi di google, il valore dell'intera pagina e ciò possa influire negativamente sul posizionamento dell'intero sito.

Grazie in anticipo per eventuali pareri.

Daniele